- Home

- Fabricantes

- NVIDIA Corporation

- NVIDIA Virtual Compute Server

NVIDIA Virtual Compute Server

Acelerando as Cargas de Trabalho de Servidores que Mais Exigem Computação.

Os workflows de AI, deep learing e ciência de dados exigem uma quantidade sem precedentes de poder de computação. O NVIDIA Virtual Compute Server (vCS) permite aos data centers acelerar a virtualização do servidor com as mais recentes GPUs de data center da NVIDIA, incluindo a GPU NVIDIA A100 e A30 Tensor Core, para que as cargas de trabalho com computação mais intensa, como inteligência artificial, deep learing e ciência de dados, possam ser executadas em uma máquina virtual (VM) com tecnologia NVIDIA vGPU. Esta não é uma etapa marginal para a virtualização; é um grande salto.

Fabricante: NVIDIA Corporation

Descrição detalhada do produto

SOLICITE SEU ORÇAMENTO

- Dimensionadas para garantir máxima eficiência.

As GPUs virtuais da NVIDIA oferecem praticamente o mesmo desempenho que o de um sistema bare-metal em um ambiente virtualizado, além de uso, gerenciamento e monitoramento máximos em um ambiente de virtualização baseado em hipervisor para a AI acelerada por GPU.

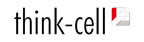

- Dimensionamento do Desempenho para o Treinamento de Deep Learning com o vCS em GPUs NVIDIA A100 Tensor Core.

Desenvolvedores, cientistas de dados, pesquisadores e estudantes precisam de muita potência computacional para realizar o treinamento de deep learning. A GPU A100 Tensor Core acelera a carga de trabalho, permitindo que eles façam mais com mais rapidez. O Servidor de Computação Virtual da NVIDIA oferece quase o mesmo desempenho que o de um sistema bare-metal, mesmo com o dimensionamento para modelos grandes de treinamento de deep learning que usam várias GPUs.

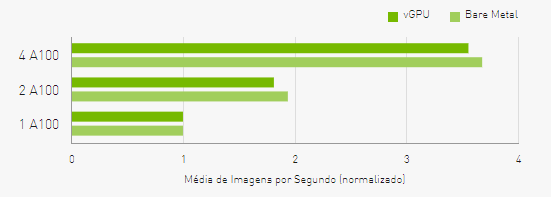

- Desempenho para o Rendimento de Inferências de Deep Learning com a MIG em GPUs NVIDIA A100 Tensor Core Usando o vCS.

A GPU Multi-Instância (MIG - Multi-Instance GPU) é uma tecnologia exclusiva da GPU NVIDIA A100 Tensor Core, que divide a A100 em até sete instâncias, cada uma totalmente isolada com sua própria memória de alta largura de banda, cache e núcleos de computação. É possível usá-la com o Servidor de Computação Virtual, uma VM por instância da MIG. O vCS garante desempenho consistente na execução de cargas de trabalho de inferência em várias instâncias da MIG em ambientes virtualizados e bare-metal.

- Recursos para gerentes de IT.

Saiba como o Servidor de Computação Virtual da NVIDIA ajuda a maximizar a produtividade e simplificar o gerenciamento da IT.

- Otimização do Uso.

Use os valiosos recursos da GPU para provisionar, sem problemas, o compartilhamento da GPU para cargas de trabalho mais leves, como a de inferência, ou várias GPUs virtuais para cargas de trabalho que exigem muita computação, como a de treinamento de deep learning.

- Capacidade de Gerenciamento e Monitoramento.

Garanta a alta disponibilidade e o tempo de atividade dos sistemas usados por cientistas de dados e pesquisadores. Monitore facilmente o desempenho da GPU no nível do convidado, do host e da aplicação. É possível até usar ferramentas de gerenciamento, como suspensão/retomada e migração dinâmica. Saiba mais sobre as vantagens operacionais da virtualização da GPU.

Obrigado! Logo entraremos em contato!